有道在线翻译爬虫是一种通过编写程序模拟浏览器行为,自动化地从有道翻译网站获取翻译结果的技术。其核心在于通过分析前端与服务器之间的网络请求,找出提供翻译服务的API接口,并破解其中的加密参数(如salt、sign等),从而实现对翻译功能的程序化调用。尽管这是一种常见的技术学习手段,但其稳定性和合规性远不如官方提供的服务。

- 为什么开发者热衷于研究有道在线翻译爬虫?

- 搭建爬虫前的准备工作:你需要什么?

- 核心步骤:如何分析有道翻译的API请求?

- 使用开发者工具定位关键请求

- 拆解API请求参数的含义

- 破解反爬虫关键:Salt与Sign参数的生成逻辑

- 什么是Salt和Sign?

- JavaScript逆向工程入门

- 使用Python复现加密算法

- Python实战:编写一个基础的有道在线翻译爬虫

- 爬虫进阶:处理常见的反爬虫策略

- 自建爬虫的挑战与局限性

- 维护成本高昂

- 稳定性和性能瓶颈

- 法律与合规风险

- 更优选择:为什么官方API是专业开发的首选?

- 无可比拟的稳定性与可靠性

- 丰富的语种与功能支持

- 合法合规,规避法律风险

- 专业的服务与技术支持

- 有道翻译爬虫常见问题解答 (FAQ)

- 爬取结果为空或返回错误代码怎么办?

- 频繁请求被封IP了如何解决?

- 学习爬虫技术是否违法?

为什么开发者热衷于研究有道在线翻译爬虫?

对于许多编程爱好者和开发者而言,研究和实现一个有道在线翻译爬虫是一个极具吸引力的技术挑战。首先,这是一个绝佳的学习机会。通过实践,开发者可以深入理解HTTP协议、浏览器工作原理、前后端数据交互流程以及基础的反爬虫与反-反爬虫技术。从分析网络请求到逆向解析JavaScript加密算法,整个过程涵盖了Web开发和网络安全的多个重要知识点。

其次,对于一些小规模的、非商业性的个人项目,开发者可能希望集成翻译功能,但又不想承担调用商业API的费用。在这种情况下,构建一个简单的爬虫似乎成了一个“零成本”的解决方案,能够满足临时的、低频次的翻译需求。这种探索精神驱动着许多人去尝试破解其工作机制,并将其应用于自己的小工具或应用中。

搭建爬虫前的准备工作:你需要什么?

在着手编写代码之前,一套合适的工具和环境是必不可少的。这些准备工作将为后续的API分析和代码实现奠定坚实的基础。

首先,你需要一个现代的网页浏览器,例如 *Google Chrome* 或 *Mozilla Firefox*。这些浏览器内置了强大的开发者工具(通常通过按 `F12` 键访问),这是分析网络流量、查看源代码和调试JavaScript的关键。其中的“网络(Network)”面板是你最重要的盟友,它能捕获所有页面加载时发出的HTTP请求。

在编程环境方面,Python 是目前网络爬虫领域最主流的语言。你需要安装Python解释器,并配置好包管理工具pip。此外,几个核心的Python库是必需的:`requests` 库用于发送HTTP请求,是与服务器进行通信的基础;`json` 库用于解析服务器返回的JSON格式数据;以及 `hashlib` 库,它在复现加密算法(如MD5)时会派上用场。

核心步骤:如何分析有道翻译的API请求?

成功爬取数据的关键在于精确模拟浏览器的请求行为。要做到这一点,我们必须先弄清楚当你在网页上输入文字并点击翻译按钮时,浏览器究竟在后台做了什么。这个过程就像是侦探破案,需要细致地观察和分析。

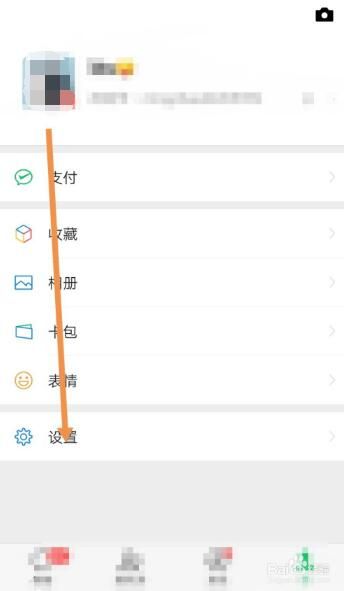

使用开发者工具定位关键请求

第一步是在浏览器中打开有道翻译网站,并启动开发者工具(`F12`)。切换到“网络(Network)”面板,并勾选“保留日志(Preserve log)”以防止页面跳转时请求记录被清空。现在,在翻译框中输入任意单词(例如“hello”),然后点击翻译按钮。你会看到网络面板中涌现出一系列新的网络请求。

在这些请求中,你需要找到那个真正负责提交待翻译内容并返回结果的API请求。通过筛选XHR(XMLHttpRequest)类型的请求,可以快速缩小范围。通常,这个请求的名称会与“translate”或“fanyi”相关。点击该请求,在“标头(Headers)”选项卡中,你可以看到请求的URL、请求方法(通常是POST)、表单数据(Form Data)以及请求头(Request Headers)等所有重要信息。

拆解API请求参数的含义

在定位到关键的API请求后,最重要的工作就是分析它所携带的参数。这些参数通常以表单数据的形式发送。你会看到一长串的键值对,其中一些是解密的关键。虽然参数名可能会随着网站更新而变化,但其核心功能通常保持不变。

以下是一些常见的请求参数及其可能的作用:

| 参数名 | 可能的作用 | 说明 |

|---|---|---|

| i | 待翻译的文本 | 这是你需要翻译的原文,例如“hello”。 |

| from | 源语言 | 通常是`AUTO`,表示自动检测。 |

| to | 目标语言 | 例如`AUTO`或`zh-CHS`(简体中文)。 |

| salt | 盐值 | 一个随机数,用于增加加密的复杂性,防止重放攻击。 |

| sign | 签名 | 通过特定算法(包含待翻译文本、salt等)生成的加密字符串,用于验证请求的合法性。 |

| lts | 时间戳 | 通常是13位的Unix时间戳(毫秒级),也可能参与签名生成。 |

| bv | 浏览器版本标识 | 一个固定的字符串,可能与浏览器的User-Agent有关。 |

其中,`i`、`from` 和 `to` 比较直观,而 `salt` 和 `sign` 是反爬虫机制的核心。服务器会根据接收到的参数,用同样的算法计算一次 `sign`,并与请求中携带的 `sign` 进行比对。如果两者不一致,请求就会被拒绝。

破解反爬虫关键:Salt与Sign参数的生成逻辑

要让爬虫程序正常工作,就必须模拟浏览器生成`salt`和`sign`这两个动态参数。这意味着我们需要找到并理解其背后的JavaScript加密逻辑,然后用Python等语言将其复现出来。

什么是Salt和Sign?

在密码学中,Salt(盐) 是一种随机数据,它与原始数据(如密码或待加密文本)结合在一起,然后进行哈希处理。它的主要作用是增加破解难度。即使两个用户输入了完全相同的原文,由于salt不同,最终生成的哈希值(即签名)也完全不同。这使得攻击者无法使用预先计算好的“彩虹表”进行快速破解。

Sign(签名) 则是一个经过哈希函数(如MD5或SHA)处理后得到的字符串。它作为请求的“指纹”,向服务器证明这个请求是“合法的”,因为它遵循了前端预设的加密规则。`sign`通常由待翻译文本、salt、时间戳以及其他一些固定字符串拼接后生成。

JavaScript逆向工程入门

寻找加密逻辑的起点通常在开发者工具的“发起程序(Initiator)”或“调用堆栈(Call Stack)”中。它可以帮助你追溯到是哪一段JavaScript代码发起了这个API请求。你也可以在“来源(Sources)”面板中,通过搜索API的URL或`salt`、`sign`等关键词来定位相关的JS文件。

找到可疑的JS文件后,工作就变成了阅读和理解这些通常经过混淆和压缩的代码。你需要耐心地理清代码逻辑,找出`salt`是如何生成的(通常与时间戳和随机数有关),以及`sign`是如何通过拼接多个变量并调用MD5等哈希函数计算出来的。这是一个充满挑战但 rewarding 的过程。

使用Python复现加密算法

一旦你理解了JavaScript中的加密逻辑,下一步就是用Python代码将其翻译过来。例如,如果JS代码是 `sign = md5(“client” + text + salt + “key”)`,那么在Python中,你可以使用 `hashlib` 库来实现同样的功能。

你需要获取当前的时间戳来生成`lts`和`salt`,然后将待翻译文本`i`、新生成的`salt`以及从JS中找到的固定字符串(密钥)按照正确的顺序拼接起来,最后使用`hashlib.md5()`进行哈希计算,得到`sign`。这个过程要求非常精确,任何一个字符或顺序的错误都会导致签名验证失败。

Python实战:编写一个基础的有道在线翻译爬虫

在掌握了API分析和加密逻辑复现之后,我们就可以将所有部分整合起来,编写一个完整的Python脚本。这个脚本将模拟从生成参数到发送请求再到解析结果的全过程。

一个基础的脚本通常包含以下几个部分:

1. 导入必要的库:主要是 `requests`, `time`, `random`, `hashlib`, 和 `json`。

2. 定义核心参数:设置API的URL、请求头(特别是 `User-Agent`, `Referer`, 和 `Cookie`),这些信息都可以从浏览器开发者工具中直接复制。

3. 实现加密函数:编写函数来生成时间戳`lts`、盐值`salt`和签名`sign`。这部分代码是你逆向工程的成果。例如,`salt`可能是时间戳加上一个随机数,而`sign`则是对特定字符串组合的MD5哈希值。

4. 构建主函数:接收用户输入的待翻译文本,调用加密函数生成动态参数,将所有参数组合成表单数据`data`,然后使用 `requests.post()` 方法发送请求。

5. 解析和输出结果:服务器返回的数据通常是JSON格式。你需要使用 `response.json()` 来解析它,然后从复杂的嵌套字典中提取出最终的翻译结果并打印出来。同时,做好异常处理,以应对网络错误或API返回错误信息的情况。

爬虫进阶:处理常见的反爬虫策略

当你成功实现一个基础爬虫后,很快就会遇到更高级的反爬虫机制,尤其是在进行频繁请求时。网站运营方会采取多种策略来阻止自动化的程序访问。

最常见的策略之一是 IP地址封禁。如果服务器检测到某个IP在短时间内发起了大量请求,它可能会暂时或永久地封禁该IP。为了应对这种情况,开发者通常会使用代理IP池。通过在每次请求时切换不同的代理IP,可以有效分散请求来源,降低被封禁的风险。

另一个策略是 User-Agent校验 和 Cookie验证。服务器会检查请求头中的`User-Agent`,以确保请求看起来像是来自一个真实的浏览器而非脚本。因此,在爬虫中设置一个常见的浏览器`User-Agent`是基本操作。某些情况下,服务器还依赖`Cookie`来跟踪会话状态,这时你需要先访问一次首页以获取初始`Cookie`,并在后续的API请求中携带它。

自建爬虫的挑战与局限性

尽管构建爬虫是一个有趣的技术练习,但将其用于实际的、持续性的应用中会面临诸多严峻的挑战。这些挑战使得自建爬虫往往不是一个可靠的长期解决方案。

维护成本高昂

最大的问题在于网站的频繁更新。为了对抗爬虫,有道翻译的前端和API会不定期地调整加密算法、更改请求参数或更新接口URL。任何微小的变动都可能导致你精心编写的爬虫瞬间失效。这意味着你需要投入持续的时间和精力去监控网站变化,并相应地更新你的代码,维护成本非常高。

稳定性和性能瓶颈

自建爬虫的稳定性极差。你无法保证服务的响应时间,因为你依赖的是一个非公开且不受你控制的接口。当网站流量过大或进行维护时,你的爬虫也会受到影响。此外,出于自我保护,网站服务器对非正常访问(如爬虫)的容忍度很低,一旦请求频率稍高,就可能触发限流或封禁,导致服务中断。

法律与合规风险

从法律角度看,爬取未明确授权公开访问的数据一直处于灰色地带。大多数网站的《服务条款》(Terms of Service) 中都明确禁止使用自动化程序访问其服务。大规模或商业性地爬取数据可能构成不正当竞争,甚至引发法律纠纷。这对于任何希望长期稳定运营的项目或公司来说,都是一个不可忽视的巨大风险。

更优选择:为什么官方API是专业开发的首选?

面对自建爬虫的种种不确定性和风险,一个显而易见且更为明智的选择是使用官方提供的翻译API服务。对于任何严肃的开发者或企业应用而言,官方API在稳定性、功能性、合规性和服务支持方面都具有无可比拟的优势。

无可比拟的稳定性与可靠性

与脆弱的爬虫不同,官方API是为程序化调用而设计的。它提供有服务等级协议(SLA)保障的高可用性,确保你的应用能够获得稳定、快速的翻译服务。你不必再担心因网站改版而导致功能瘫痪,因为API接口的变更会遵循规范的流程,并提前通知开发者。

丰富的语种与功能支持

官方服务,如有道智云AI开放平台,提供的远不止基础的文本翻译。它支持海量的语种对,并且集成了文档翻译、图片翻译(OCR)、语音翻译、同声传译等多种强大的AI功能。这些是简单的爬虫技术完全无法企及的,能够极大地丰富你的应用能力。

合法合规,规避法律风险

使用官方API意味着你的所有操作都是在服务提供商的授权下进行的。这从根本上解决了合规性问题,让你无需担心侵犯知识产权或违反服务条款。对于商业项目而言,合法合规是生存和发展的前提,能够让你专注于业务创新,而非法律风险。

专业的服务与技术支持

当你遇到问题时,官方API提供专业的技术支持团队来帮助你解决。无论是API的集成问题,还是功能使用上的疑问,你都能获得及时有效的帮助。此外,完善的开发文档和SDK也极大地降低了集成门槛,提升了开发效率。

有道翻译爬虫常见问题解答 (FAQ)

在探索和实践的过程中,你可能会遇到各种各样的问题。这里整理了一些常见疑问及其解答。

爬取结果为空或返回错误代码怎么办?

这通常意味着你的请求参数有误,签名验证失败。首先,请仔细检查你的加密逻辑是否与最新的网站JS代码完全一致。其次,核对请求头(`User-Agent`, `Referer`, `Cookie`)是否完整且正确。最后,确认表单数据中的所有参数,包括固定字符串和动态生成的值,是否都准确无误。使用`print`语句在代码中打印出每个参数,与浏览器开发者工具中捕获到的成功请求进行逐一比对,是排查错误的有效方法。

频繁请求被封IP了如何解决?

IP被封禁是爬虫最常遇到的问题。临时的解决方案是更换网络环境(例如重启路由器更换IP)或等待一段时间。对于需要持续运行的爬虫,根本的解决方案是使用代理IP池。你可以购买专业的代理服务,在每次请求时随机选择一个代理IP来发送请求。同时,务必在两次请求之间设置合理的随机延时(例如1-3秒),模拟人类用户的行为,降低被识别为机器人的概率。

学习爬虫技术是否违法?

单纯地学习和研究爬虫技术本身并不违法,它是一种中立的计算机技术。问题的关键在于你如何使用这项技术。如果只是用于技术研究,在合理的范围内、以较低的频率抓取公开数据,通常不会产生问题。但是,如果你的行为对目标网站的正常运营造成了干扰(例如高并发请求导致服务器瘫痪),或者你抓取、传播、使用受版权保护或涉及个人隐私的数据用于商业目的,那么就可能触犯相关法律法规。因此,始终保持对规则的敬畏,并优先考虑使用官方授权的API,是每个负责任开发者的正确选择。